최근 한 제조분야 스타트업 최고경영자(CEO)가 내놓은 한탄입니다. 이 기업은 최근 직원들의 챗GPT 활용 범위를 두고 골머리를 앓았습니다. 한 직원은 아직 비공개인 장비 사업 소개문 작성을 챗GPT에 맡겼습니다. 다른 직원은 외국 거래처에 보내는 영문 견적서 문법을 수정해달라고 했고요.

이 과정에서 주요 제품 내역과 가격, 자체 매출 전망, 경쟁사와의 차별점, 거래처 정보 등이 고스란히 챗GPT 플랫폼에 업로드 됐습니다. 내부에선 담당 팀 말고는 내용을 알 수 없도록 신신당부를 한 정보인데도 말입니다. 이 기업은 이 사건 이후 사업 관련 기밀을 챗GPT에 입력한 것이 발각될 경우 징계 조치를 받을 수 있다는 사내 공지를 내렸습니다.

2일 정보기술(IT) 업계에 따르면 삼성전자 디바이스경험(DX) 부문은 최근 내부 챗GPT 사용 지침 마련에 나섰습니다. 설문조사 어떤 업무·용도 등에 챗GPT를 쓰도록 허용할지 등을 따져볼 계획입니다.

디바이스솔루션(DS)부문은 지난달 소속 직원들이 챗GPT에 질문을 할 때 한 번에 1024바이트 이상을 업로드할 수 없도록 조치했습니다. 한 직원이 프로그램 소스코드를 챗GPT에 고스란히 업로드해 오류 확인을 요청한 이후로 내놓은 조치로 알려졌는데요. 소스코드는 프로그램의 개발 과정과 틀을 담고 있어 외부에 알려질 경우 보안 취약점이 드러날 수 있습니다.

국내 기업중엔 SK텔레콤과 SK하이닉스가 일찌감치 챗GPT 관련 가이드라인을 운영하고 있습니다. SK텔레콤은 사내 정책·전략·기술 관련 내용은 챗GPT에 입력하지 않도록 직원들에게 공지했습니다. 내부 프로그래밍 코드를 챗GPT 프롬프트에 붙여넣는 것도 금지입니다.

SK하이닉스는 아예 사내망에서 챗GPT를 사용하지 않는 것을 원칙으로 삼았습니다. 꼭 써야할 경우엔 별도 보안성 검토를 받아야 합니다.

네이버는 내부 서버에 데이터가 저장되는 형태의 서비스는 업무 목적으로 사용을 금지하고 있습니다.

반면 KT, LG유플러스, 카카오 등은 지난달 말 기준 챗GPT 관련 별도 가이드라인을 두고 있지 않습니다.

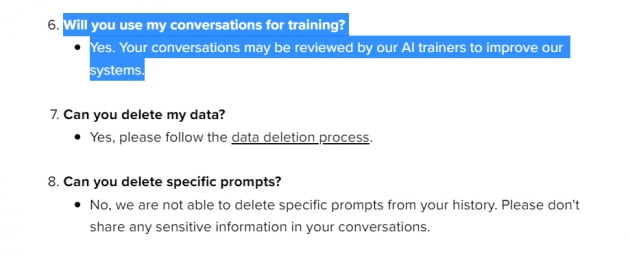

챗GPT 운영사 오픈AI도 이같은 점을 명시하고 있습니다. 지난달 업데이트 된 오픈AI의 챗GPT 도움말에 따르면 오픈AI는 모든 이용자와 챗GPT간 대화를 AI 모델 고도화를 위해 활용할 수 있습니다. 이 과정에서 AI 트레이너가 대화 내용을 검토할 수도 있다는 설명입니다.

오픈AI의 개인정보 공지도 이를 뒷받침합니다. 오픈AI는 이용자가 입력한 개인정보를 △서비스 제공·개선 △연구 △새로운 프로그램·서비스 개발 등에 쓸 수 있습니다. 사용자 데이터를 기반으로 집계한 정보는 제3자와도 공유할 수 있습니다.

한 AI업계 관계자는 “애초에 오픈AI가 챗GPT를 무료로 개방한 이유 중 하나가 데이터를 학습해 모델을 고도화하기 위한 것”이라며 “챗GPT 플랫폼에 올리는 모든 정보는 비즈니스 목적으로 수집될 수 있다고 보면 된다”고 했습니다.

오픈AI에 따르면 챗GPT를 통해 수집하는 정보는 기본적으로는 익명 혹은 비식별 형태로 저장됩니다. 어느 이용자가 어떤 정보를 입력했는지에 대해선 특정할 수 없다는 겁니다.

하지만 이는 기업 입장에선 별다른 위안이 되지 않습니다. AI가 사업 계획서를 학습해 향후 다른 이용자에게 관련 내용을 내놓을 수 있다는 것이 중요한 것이지, 최초 입력자가 박 과장인지 김 대리인지는 아주 부차적인 문제니까요.

챗GPT를 비롯한 AI 플랫폼이 해킹 공격을 받을 경우 대화 내용이 제삼자에게 그대로 노출될 가능성도 있습니다. 2021년 6월에 나온 한 연구가 이를 보여줍니다. 애플, 구글, 하버드대, 스탠포드대 등 주요 AI 관련 기업·기관 연구자 10여명이 한 공동연구였는데요. 연구자들은 GPT-2를 기준으로 AI 학습 데이터를 추출하는 사이버 공격을 통해 대화 시퀀스(과정) 전부와 개인식별정보를 뽑아낼 수 있다는 점을 발견했습니다.

보안업계에선 각 기업의 가이드라인과 직원 교육 등이 필요하다고 입을 모읍니다. 한 보안업계 관계자는 “어떤 정보든 한 번 온라인에 업로드하면 유출돼 제삼자가 활용할 가능성이 생긴다”며 “직원들이 AI플랫폼에 함부로 영업 기밀이나 개인 정보 등을 입력하지 않도록 가이드라인을 만들고 교육하는 과정이 반드시 필요하다”고 지적했습니다.

선한결 기자 always@hankyung.com

(주)한국경제신문사 | 서울시 중구 청파로 463 한국경제신문사 빌딩

(주)한국경제신문사 | 서울시 중구 청파로 463 한국경제신문사 빌딩